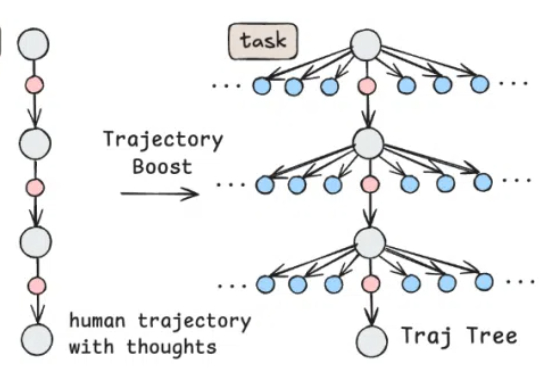

312条轨迹激发241%性能!上交大与SII开源电脑智能体,超越 Claude 3.7

312条轨迹激发241%性能!上交大与SII开源电脑智能体,超越 Claude 3.7自 Anthropic 推出 Claude Computer Use,打响电脑智能体(Computer Use Agent)的第一枪后,OpenAI 也相继推出 Operator,用强化学习(RL)算法把电脑智能体的能力推向新高,引发全球范围广泛关注。

自 Anthropic 推出 Claude Computer Use,打响电脑智能体(Computer Use Agent)的第一枪后,OpenAI 也相继推出 Operator,用强化学习(RL)算法把电脑智能体的能力推向新高,引发全球范围广泛关注。

OpenAI 研究员姚顺雨近期发布文章,指出:AI 下半场将聚焦问题定义与评估体系重构。在 AI 发展新阶段,行业需要通过设计更有效的模型评测体系,弥补 AI 能力与真实需求的差距。

今天有个爆炸性消息,OpenAI 以 65 亿美元收购了由 Sam Altman 与前苹果首席设计官 Jony Ive 联合创办的 AI 设备初创公司 io。Jony Ive 1992 年加入苹果,是全球最具影响力的工业设计大师之一,主导设计了 iMac、iPhone、iOS 7 等苹果标志性产品,也引领了全球消费电子的设计潮流。

该项目在今年1 月进一步扩大,Crusoe 与甲骨文签署了更大规模的租赁协议 ,新增 6 个数据中心,覆盖整个 1.2 吉瓦的场地,The Information 率先报道。该协议使甲骨文能为 OpenAI 提供的算力规模翻了两番,额外增加 30 万块 GPU。最初与 Blue Owl 成立的合资企业并不包含此次扩建计划。

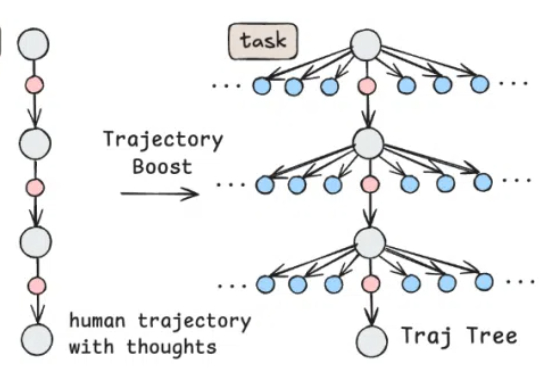

OpenAI 的 GPT-4o 在图像理解、生成和编辑任务上展现了顶级性能。流行的架构猜想是:

就在刚刚,OpenAI 正式官宣,将以接近 65 亿美元(折合人民币 468.16 亿元)的价格收购由 OpenAI CEO Sam Altman 与前苹果首席设计官 Jony Ive 联合创办的 AI 设备初创公司 io。

一份隐藏了部分关键信息的法庭文件,给我们展示了 OpenAI 的很多独家信息,特别是对 ChatGPT 的发展、如何定位自己的竞争对手以及自己的护城河在哪等。

国产大模型进步的速度早已大大超出了人们的预期。年初 DeepSeek-R1 爆火,以超低的成本实现了部分超越 OpenAI o1 的表现,一定程度上让人不再过度「迷信」国外大模型。

热门法律AI 工具 Harvey 于 5 月 13 日在博客中宣布,将不再仅依赖 OpenAI 的基础模型,开始采用 Anthropic 和谷歌的基础模型。

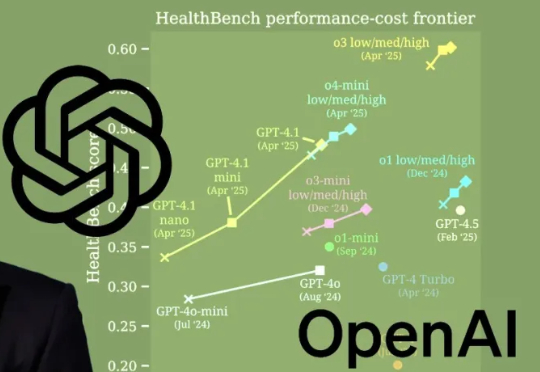

OpenAI发布新基准HealthBench,联手60个国家262名执业医生,树立新的「AGI标志性用例」。OpenAI o3碾压Grok 3和Gemini 2.5 Pro,成功登顶。而最强AI几乎达到了人类医生最佳水平!